"Mich fasziniert das große Ganze"

Vom Commodore 64 zum Supercomputer: Martin Schultz hat die Entwicklung der Datenwissenschaft hautnah miterlebt. Heute erforscht er am Forschungszentrum Jülich, wie Künstliche Intelligenz das Verständnis von Wetter und Klima verändert. Ein Gespräch über wissenschaftliche Umbrüche und interdisziplinäre Teams.

Wie hat sich Ihr Weg in die Datenwissenschaft eigentlich entwickelt – was hat Sie an Wetter- und Klimadaten besonders fasziniert?

Ich habe Physik studiert und mein Diplom in der Festkörperphysik gemacht. Danach wollte ich eigentlich ins Consulting gehen, doch ich bekam immer wieder die Rückmeldung: „Machen Sie doch erst einmal eine Promotion.“ Also habe ich mich darum gekümmert – allerdings mit einer inhaltlichen Neuorientierung, weil mich die Umweltforschung sehr interessierte. Auf diese Weise bin ich schließlich in die Atmosphärenforschung gekommen.

Gleichzeitig hatte ich schon damals ein großes Interesse an Computern – ich war einer der frühen Nutzer des Commodore 64. So habe ich mich dann in der Atmosphärenforschungen immer öfter mit datentechnischen Problemen beschäftigt.

Während meines Postdocs an der Harvard University habe dann ich hauptsächlich Programme zur Datenauswertung entwickelt. Damals ging es um große Flugzeugmesskampagnen, bei denen verschiedene Datenströme zusammengeführt werden mussten. Diese stammten aus unterschiedlichen Messgeräten und lagen mit jeweils eigener Zeitauflösung vor. Dafür war es notwendig, ein Datenformat zu schaffen, das es ermöglicht, die verschiedenen Datensätze gemeinsam zu betrachten und miteinander in Beziehung zu setzen.

Und von da ging mein Weg dann in die numerische Modellierung – zunächst von Wetterprozessen und später auch von Atmosphärenchemie. Es ging also zunächst um Transportprozesse, und dann eben um chemische Reaktionen, Umwandlungen und ähnliche Vorgänge.

Danach arbeitete ich zunächst als Wissenschaftler – und ziemlich schnell auch als Gruppenleiter – am Max-Planck-Institut für Meteorologie in Hamburg. Dort war ich verantwortlich für die Entwicklung eines Chemieteils für das Klimamodell ECHAM, das zu einem sogenannten Chemie-Klimamodell ausgebaut wurde. Diese Arbeit hat mich mehrere Jahre beschäftigt.

Über diesen Weg bin ich schließlich wieder nach Jülich zurückgekommen, wo ich auch schon meine Doktorarbeit geschrieben hatte. Dort habe ich dann die Leitung einer Gruppe für atmosphärenchemische Modellierung übernommen.

Ich war eigentlich nie der klassische Atmosphärenchemiker, der sich im Detail mit einzelnen Reaktionsmechanismen beschäftigt. Mich hat vielmehr das große Ganze fasziniert – also das gesamte Erdsystem. Mich haben die großen Zusammenhänge interessiert – also wie die verschiedenen Komponenten des Erdsystems miteinander wechselwirken, welche Rolle Transport- und Durchmischungsprozesse spielen und wie all das zusammen das Klima beeinflusst.

Und dann immer wieder die Frage: Wie bekommt man all das überhaupt effizient auf den Computer? Im Laufe der Zeit wurden die Berechnungen und Modelle immer besser, aber der Fortschritt war mühsam. Man bastelte ewig am Code, um selbst kleinste Verbesserungen zu erreichen.

Unser Gesprächspartner Martin Schultz

Martin Schultz

Martin Schultz leitet am Forschungszentrum Jülich die Forschungsgruppe Earth System Data Exploration und ist Co-Leiter der Abteilung Large Scale Data Science. Außerdem ist er Professor für Computational Earth System Science an der Universität zu Köln.

Seine Forschung konzentriert sich auf den Einsatz von Künstlicher Intelligenz und Deep Learning zur Analyse von Wetter-, Klima- und Luftqualitätsdaten sowie auf die Entwicklung von Dateninfrastrukturen und Webdiensten für großskalige Erdsystemdaten.

Wie kam dann der Schritt hin zum Einsatz von Machine Learning und Künstlicher Intelligenz in Ihrer Forschung?

Schultz: Ich hatte mich schon früh mit dem Thema beschäftigt, aber der eigentliche Durchbruch war für mich 2012, als ich ein Paper las, in dem künstliche Bilderkennung erstmals mit der menschlichen vergleichbar war. Das war für mich ein echter Aha-Moment. Ich dachte, dass sich solche Methoden doch auch auf Wetterphänomene und atmosphärische Prozesse anwenden lassen müssen. Schließlich betrachtet man in der Wettervorhersage auch oft animierte Bildsequenzen, und das ist nicht viel anders als ein Video.

Kurz darauf habe ich einen Antrag für einen ERC Advanced Grant gestellt, um KI-Methoden auf chemische Prozesse in der Atmosphäre anzuwenden – und zum Glück wurde er bewilligt. Damit hatte ich sozusagen mein Startkapital, um am Forschungszentrum Jülich eine eigene Arbeitsgruppe aufzubauen, die sich mit der Entwicklung solcher KI-Ansätze beschäftigt. Das war 2018. Von da an ging es dann tatsächlich rasant voran.

2022 dann konnten mehrere Modelle mindestens genauso gute Wettervorhersagen produzieren wie die die klassischen. Das hat dann wirklich die gesamte Community wachgerüttelt.

Bevor in der Öffentlichkeit also überhaupt groß über KI gesprochen wurde, haben Sie ja schon auf dem Gebiet gearbeitet. Was waren damals die größten Herausforderungen?

Martin Schultz: Zunächst ging es natürlich darum, das Methodische überhaupt zu begreifen: Was passiert da eigentlich? Wie funktioniert das?

Es gibt eine Art Schwelle, ab der das maschinelle Lernen von einer rein statistischen Methode zu etwas wirklich Neuem wird – zu einem Ansatz, der plötzlich bahnbrechende Ergebnisse ermöglicht. Das hängt sowohl mit der Modellgröße als auch mit neuen Modellkonzepten zusammen. Genau das zu verstehen – also was da passiert und wie dieser Umschwung funktioniert – war eine der großen Herausforderungen am Anfang.

Eine weitere Herausforderung war das Umdenken von einer prozessorientierten zu einer datenorientierten Herangehensweise. Mir wurde relativ schnell klar, dass man an viele Modellierungsprobleme ganz anders herangehen muss, wenn man sie mit KI lösen will. In den Naturwissenschaften versucht man ja traditionell, ein Problem so weit zu vereinfachen, dass man es vollständig versteht und in Gleichungen fassen kann. Der KI-Ansatz ist dagegen fast das Gegenteil: Je mehr Daten man hat – auch wenn sie nicht perfekt oder vollständig strukturiert sind –, desto besser kann man ein Modell trainieren und desto mehr Erkenntnisse lassen sich daraus gewinnen.

Ich hätte es nie für möglich gehalten, dass ich in meiner Karriere einen solchen Umbruch in der Wissenschaft miterlebe.

Also statt klein – groß denken. Inzwischen hat sich die KI rasant weiterentwickelt. Was hat sich dadurch für Ihre Arbeit am meisten verändert?

Ich hätte es nie für möglich gehalten, dass ich in meiner Karriere einen solchen Umbruch in der Wissenschaft miterlebe. Dass man nicht einfach bestehende Methoden ein wenig weiterentwickelt und kleine Fortschritte erzielt, sondern dass wirklich ein radikaler Bruch passiert – das ist außergewöhnlich. Und dass ich dabei ganz vorne mit dabei sein kann, ist einfach ein großartiges Erlebnis, muss ich sagen.

Was sich dadurch in der täglichen Arbeit verändert hat, ist natürlich auch die Zusammenarbeit. Bis vor etwa zehn Jahren habe ich im Wesentlichen mit anderen Meteorologinnen, Atmosphärenchemikern und verwandten Fachleuten gearbeitet. Seit 2017 bin ich auch am Supercomputing Center tätig – dadurch gab es zunehmend Austausch mit Expertinnen und Experten, die sich mit Rechnerarchitekturen und Hochleistungsrechnen beschäftigen.

Ganz neu hinzugekommen ist in den letzten Jahren aber die KI-Community – mit der hatte ich vorher kaum Berührungspunkte. Da musste ich mir zunächst ein entsprechendes Netzwerk aufbauen. Das spiegelt sich auch in der Zusammensetzung meiner Arbeitsgruppe wider: Inzwischen haben wir fast das umgekehrte Problem wie früher. Früher waren wir überwiegend Fachwissenschaftler, heute besteht der größere Teil des Teams aus Informatikerinnen und Ingenieuren. Viele von ihnen bringen exzellente Machine-Learning-Expertise mit, sind aber weniger vertraut mit atmosphärischen Prozessen.

Die Herausforderung besteht also darin, die richtige Balance zu finden: Wie viel Domänenwissen braucht man, wie viel Machine-Learning-Kompetenz – und zusätzlich auch noch ein gutes Maß an Engineering, um die Methoden effizient auf Hochleistungsrechnern umzusetzen. Diese Mischung macht die Arbeit anspruchsvoll, aber auch unglaublich spannend – gerade, wenn es darum geht, so eine Gruppe aufzubauen und zu leiten.

Wenn Sie an die nächsten Jahre denken: Welche Rolle wird KI in der Klima- und Wetterforschung künftig spielen – und wo sehen Sie vielleicht auch Grenzen?

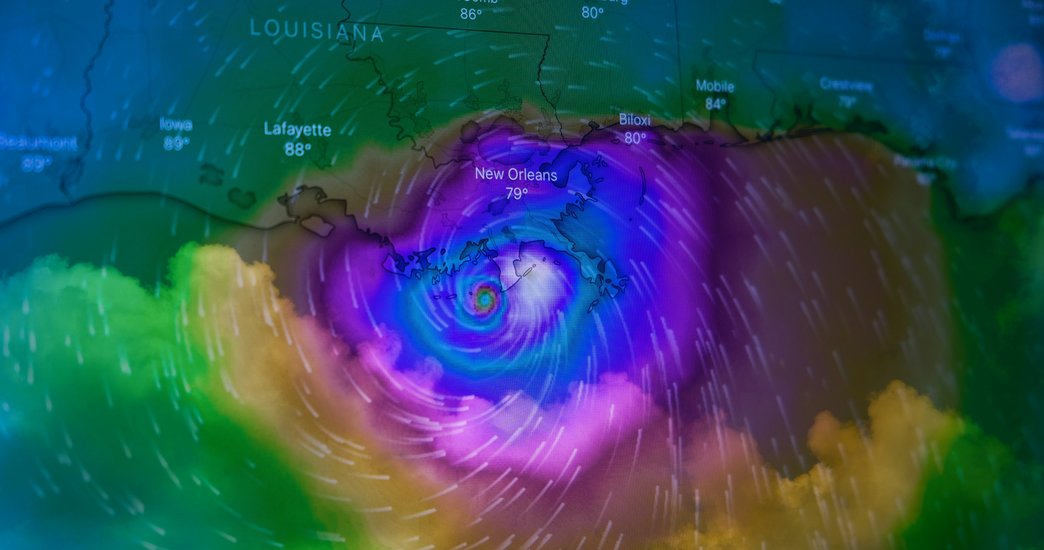

In der Wetterforschung und Wettervorhersage sieht man sehr deutlich, dass KI mittlerweile eine zentrale Rolle spielt. Viele operationelle Zentren – etwa das Europäische Zentrum für mittelfristige Wettervorhersage oder auch der Deutsche Wetterdienst – gehören dabei zur internationalen Spitze. Besonders in Europa werden KI-Modelle inzwischen zunehmend auch im operativen Betrieb eingesetzt.

Derzeit basieren die wirklich entscheidenden Vorhersagen, also dort, wo es auf höchste Genauigkeit ankommt, weiterhin auf den klassischen numerischen Modellen. Aber KI-Modelle laufen mittlerweile parallel im Betrieb, werden in die Auswertung einbezogen und ergänzen die klassischen Verfahren zunehmend.

Beim Klima ist das deutlich schwieriger. Hier ist man aktuell so weit, dass man sogenannte Klimasimulatoren entwickeln kann – also KI-Modelle, die klassische Klimamodelle nachahmen. Diese übernehmen aber natürlich auch die Fehler, die in den klassischen Modellen enthalten sind. Trotzdem ist das sehr sinnvoll, weil man damit wesentlich mehr Szenarien durchrechnen und große Modell-Ensembles aufstellen kann. Man spart enorme Rechenzeit und erhält dadurch oft detailliertere Ergebnisse – auch wenn die grundlegenden Unsicherheiten noch dieselben bleiben.

Im Rahmen der Helmholtz-Foundation-Model-Initiative gehen wir einen Schritt weiter und arbeiten an der Frage, wie man über diese Grenze hinauskommt. Also, wie man hinkommt zu KI-Modellen, die das Klima wirklich eigenständig simulieren können und nicht nur bestehende Modelle nachbilden.

Da gibt es durchaus Hoffnung: Einerseits, weil es noch viele Daten gibt, die in der klassischen Modellierung bislang kaum genutzt werden. Andererseits, weil man versuchen kann, eine Art Mittelweg zu finden – also die Stärken der klassischen Wettermodelle zu nutzen, um beispielsweise Antriebsdaten aus Klimamodellen mit ihren Fehlern zu korrigieren und an das reale Wetter anzupassen. Wenn diese Korrekturen auch unter veränderten Klimabedingungen funktionieren, hätte man tatsächlich ein besseres, robusteres Klimamodell geschaffen.

Martin Schultz beim Career Day – jetzt anschauen!

Warum lassen sich KI-Methoden in der Wetterforschung so viel einfacher anwenden als in der Klimaforschung?

Martin Schultz: Der wesentliche Grund liegt darin, dass wir in der Wetterforschung eine sehr viel größere Menge an Beobachtungsdaten haben. Dazu kommen die sogenannten Reanalysen, die das Wetter über mehrere Jahrzehnte hinweg sehr systematisch und konsistent simuliert haben – und das mit erstaunlich hoher Qualität.

Natürlich ist das nicht „die Wahrheit“, wie manche glauben. Auch in den Reanalysen gibt es Fehler, aber näher kommt man an die Realität mit klassischen Modellansätzen kaum heran. Deshalb können KI-Modelle in der Wettervorhersage inzwischen mindestens so gut werden wie die klassischen Modelle – teilweise sogar besser. Tatsächlich zeigen sich mittlerweile Beispiele, in denen KI-Modelle über längere Zeiträume hinweg stabilere und genauere Vorhersagen liefern.

Neuere Studien, die Beobachtungsdaten direkt in die Modelle einfließen lassen, zeigen zudem, dass KI-Methoden diese Daten deutlich besser ausnutzen können. In der klassischen Datenassimilation werden vielleicht zehn bis fünfzehn Prozent der verfügbaren Daten genutzt – KI-Modelle können dagegen bis zu 75 oder 80 Prozent einbeziehen. Dadurch entstehen sehr viel detailliertere Informationen, die die Wettervorhersage weiter verbessern.

Im Klimasystem ist die Situation eine ganz andere. Auf den langen Zeitskalen haben wir deutlich weniger Beobachtungsdaten, und in einigen Bereichen – etwa in den Tiefen des Ozeans oder bei Eisschilden – sind belastbare Messungen extrem schwierig. Viele Prozesse sind zudem weniger gut verstanden. In der Modellierung geht es hier um enorme Skalenunterschiede: von winzigen Rissen im Eis bis hin zum großflächigen Abbrechen ganzer Gletscherteile. Solche Prozesse lassen sich in numerischen Simulationen bislang nur sehr eingeschränkt darstellen. Es ist beeindruckend, was heute schon möglich ist, aber die Unsicherheiten sind nach wie vor groß.

Hinzu kommt, dass das Klimasystem aus einer Vielzahl miteinander verknüpfter Prozesse besteht – etwa im Kohlenstoffkreislauf, in der Energiebilanz oder der Feuchtebilanz. Man denke nur an das Auftauen von Permafrostböden, bei dem Methan freigesetzt wird. Diese Prozesse laufen auf ganz unterschiedlichen Zeitskalen ab – von Stunden bis zu Jahrhunderten.

Genau diese Kopplung der Zeitskalen ist etwas, das in heutigen KI-Modellen überhaupt nicht abgebildet wird – und für das ich bislang auch keine Modellarchitektur kenne, die das leisten könnte. Es gibt erste Ideen und Ansätze, wie man so etwas vielleicht ermöglichen kann, aber davon sind wir noch weit entfernt.

Und genau das macht es spannend: Es ist eine Problemstellung, die es in anderen Bereichen – etwa bei großen Sprachmodellen – in dieser Form gar nicht gibt. Das bedeutet auch, dass es keine so breite KI-Community gibt, die sich mit diesen spezifischen Herausforderungen beschäftigt. In der Wettermodellierung war das noch anders – da gab es viele, die an ähnlichen Problemen gearbeitet haben. Jetzt ist es eine ganz neue Art von Herausforderung.

Man sollte sich nicht nur auf Modelle und Methoden fixieren, sondern wirklich ein Verständnis und eine Neugier für Daten entwickeln.

Was würden Sie jungen Menschen raten, die sich für Data Science interessieren und etwas zur Klimaforschung beitragen möchten?

Also, vielleicht erst mal mein Blick auf die Data Science. Ich muss tatsächlich sagen: Für mein Empfinden ist der Begriff Data Science schon fast wieder ein bisschen aus der Mode gekommen. Und zwar in dem Sinne, dass das, was man klassisch unter Data Science versteht – also statistische Methoden auf Daten anwenden, Daten kuratieren, sammeln und dann statistisch auswerten – heute eigentlich nur noch einen Teilbereich abdeckt.

Der Bereich des Machine Learning hat sich davon inzwischen ein Stück weit abgekoppelt. Die Verfahren und Methoden, die man heute im Machine Learning entwickelt und einsetzt, sind oft ganz andere – die finden sich so in klassischen Data-Science-Kursen kaum noch. Selbst an den Universitäten gibt es dafür inzwischen eigene Vorlesungen und Studienrichtungen.

Und ich kann im Moment wirklich jedem nur raten, sich mit Machine Learning intensiv auseinanderzusetzen. Ich sehe da eine riesige Zukunft – ehrlich gesagt mehr als in den klassischen Data-Science-Methoden. Natürlich bleibt vieles davon wichtig: Auch im Machine Learning gilt ja immer noch, dass rund 90 Prozent der Arbeit in der Datenaufbereitung steckt und vielleicht 10 Prozent in der eigentlichen Modellierung. Das heißt, das Interesse an Daten ist ganz entscheidend. Man sollte sich also nicht nur auf Modelle und Methoden fixieren, sondern wirklich ein Verständnis und eine Neugier für Daten entwickeln.

Aus meiner Erfahrung lohnt es sich außerdem, frühzeitig einen Fokus zu setzen – der muss nicht lebenslang gelten, aber zumindest für einige Jahre. Also sich auf eine bestimmte Art von Daten zu konzentrieren und die wirklich zu verstehen. In der Klimaforschung können das zum Beispiel Satellitendaten sein, oder Daten aus Klimamodellen. Vielleicht auch noch etwas enger gefasst: Ozeandaten, Landdaten oder Atmosphärendaten.

Wichtig ist, dass man sich eine eigene Perspektive und Expertise erarbeitet – also weiß, was die Potenziale und auch die Grenzen dieser Daten sind. Darauf kann man dann gezielt Methoden entwickeln und anwenden. Ich glaube, dieses Vorgehen ist langfristig das Sinnvollste.