Wie aus Daten Wissen wird

Die Sammelleidenschaft der Moderne hat einen Namen: Big Data. Die Wissenschaft muss gewisse Regeln befolgen und die richtige Infrastruktur nutzen, um den Datenschatz zu heben. Zwei Beispiele vom Forschungszentrum Jülich zeigen, wie es geht.

Menschen sammeln gerne. Bei einigen gehören Sammeln und Verwahren sogar zum Beruf. Dazu zählen Wissenschaftler. Sie häufen nicht nur Wissen an, sondern produzieren und erfassen auch Unmengen von Daten und Informationen, aus denen Erkenntnis erst noch entstehen muss.

Die moderne Technik erleichtert das Erheben von Daten ungemein und verführt zum Horten. Experten schätzen, dass 90 Prozent der weltweit verfügbaren Daten erst in den vergangenen zwei Jahren zusammengetragen wurden. In der Wissenschaft erzeugen immer genauere Versuchsgeräte, Messsysteme und Computersimulationen immer größere Berge an Daten. Am CERN, der Europäischen Organisation für Kernforschung, fallen bei Experimenten jährlich etwa 50 Petabyte Daten an, das Jülich Supercomputing Centre (JSC) kommt alleine bei Simulationen auf rund 20 Petabyte Daten pro Jahr. Bei solchen Datenmengen sprechen Experten von Big Data, von Daten, die sich mit manuellen und herkömmlichen Methoden nicht mehr auswerten lassen.

Big Data ist weit mehr als eine Sammelleidenschaft. Es bietet die Chance, aus den vielen Daten neue Zusammenhänge und Muster aufzudecken, die in kleinen Stichproben nicht auffallen würden. Doch „Big“ alleine bringt keine neuen Erkenntnisse. Ordnen, filtern, auswerten, aber auch Daten teilen und austauschen – das sind die großen Herausforderungen, um aus Big Data Smart Data zu machen, also Daten, aus denen sich sinnvolle Informationen gewinnen lassen. Diese Herausforderungen stellen neue Ansprüche an die IT-Infrastruktur, den Umgang mit Daten und die Zusammenarbeit in der Wissenschaft. Zwei Jülicher Beispiele zeigen, was Big Data im Forscheralltag bedeutet.

1,4 Milliarden Messpunkte

Alte Hasen im Big-Data-Geschäft sind Dr. Andreas Petzold und seine Kollegen vom Jülicher Institut für Energie- und Klimaforschung (IEK-8). „Im Projekt IAGOS reisen unsere Messgeräte seit über 20 Jahren mit kommerziellen Linienflugzeugen rund um die Welt. Dabei nehmen sie während des Flugs alle 4 Sekunden eine Messung vor: zum Beispiel, um Treibhausgase wie Kohlendioxid und Methan, weitere reaktive Spurengase wie Ozon, Kohlenmonoxid und Stickoxide, aber auch Feinstaub sowie Eis und Wolkenteilchen zu erfassen. In der Zeit sind über 1,4 Milliarden Messpunkte auf 320 Millionen Flugkilometern zusammengekommen.“ Dass sich solche Datenmengen nicht mehr mit dem Taschenrechner auswerten lassen, versteht sich von selbst. Die Wissenschaftler mussten maßgeschneiderte Softwarepakete entwickeln: etwa für die Kalibrierung der Geräte, die Übertragung der Daten und deren Auswertung.

Die Klimadaten dienen dazu, langfristige Trends zu erkennen, zum Beispiel zur Luftverschmutzung oder zu Treibhausgasen. Solche globalen Daten und Erkenntnisse sind für Forscher weltweit von Interesse. Gerade beim Klima ist es wichtig, Daten aus verschiedenen Quellen zusammenzuführen – auch weil hier zahlreiche Faktoren ineinandergreifen: Böden, Pflanzen, Tiere, Mikroorganismen, Gewässer, Atmosphäre und alles, was der Mensch so treibt.

Daten vergleichbar machen

Bislang werden solche Daten noch zu häufig getrennt voneinander erfasst und auch getrennt in Modelle gepackt. Das soll sich ändern: Auf europäischer Ebene starteten Anfang 2019 mehrere groß angelegte Infrastrukturprojekte, die nicht nur auf die langfristige und gut strukturierte Sicherung der einzelnen Datenschätze zielen, sondern zusätzlich auf deren Vergleichbarkeit.

Wenn Forscher aus verschiedenen Disziplinen, Einrichtungen und Ländern ihre Datenberge zu noch größeren Datenbergen auftürmen, ist erst einmal eines gefragt: gemeinsame Standards. Die gibt es bisher noch zu selten. Solche Regeln sollen von den Erhebungsmethoden im Feld, über die Qualitätssicherung von Messungen bis hin zur Überprüfbarkeit der Daten reichen. Innerhalb von Projekten gibt es diese Standards bereits: „Im IAGOS-Projekt zum Beispiel versehen wir jeden Messpunkt mit einer ganzen Reihe von Metadaten. Das sind quasi die Schlagwörter zu jeder Messung: was, wann, wie und wo, Temperatur, Flugnummer und Messgerät. Dadurch können auch externe oder nachfolgende Forscher nachvollziehen, was wir wie und wo gemessen haben“, betont Petzold.

Wenn Forscher aus verschiedenen Disziplinen, Einrichtungen und Ländern ihre Datenberge zu noch größeren Datenbergen auftürmen, ist erst einmal eines gefragt: gemeinsame Standards.

EU-Mammutprojekt für 19 Millionen Euro

Nun sind projektübergreifende Standards gefragt. Genau die will ENVRI-FAIR einführen, das europäische Infrastrukturprojekt für die Umweltwissenschaften. ENVRI steht für Environmental Research Infrastructures, denn alle etablierten europäischen Infrastrukturen der Erdsystemforschung sind an dem Vorhaben beteiligt – von lokalen Messstationen über mobile Geräte wie die von IAGOS bis hin zu satellitengestützten Systemen. FAIR beschreibt die Ansprüche, wie Forscher künftig die Unmengen an Daten erfassen und speichern sollen: auffindbar (findable), zugänglich (accessible), untereinander austauschbar (interoperable) und wiederverwertbar (reusable).

Petzold koordiniert dieses Mammutprojekt, das für vier Jahre mit 19 Millionen Euro von der EU gefördert wird. „ENVRI-FAIR wird es uns ermöglichen, unterschiedliche Daten miteinander zu verknüpfen und in Beziehung zueinander zusetzen – die Grundlage dafür, dass aus unseren Big Data auch Smart Data werden, die für die Forschung, für Innovationen und die Gesellschaft nutzbar sind“, betont er. Damit möglichst viele Forscher auf die Datenschätze zugreifen können, ist wie bei allen anderen europäischen Infrastrukturprojekten ein offener Zugriff über die European Open Science Cloud geplant, die gerade aufgebaut wird.

Um solche ambitionierten Pläne zu verwirklichen, benötigen die Fachwissenschaftler die Unterstützung von IT-Spezialisten – beispielsweise für den anstehenden Ausbau von IT-Infrastrukturen sowie Datenverwaltungs- und Computerzentren. Am Forschungszentrum Jülich steht das Jülich Supercomputing Centre (JSC) als Partner mit weitreichender Expertise zur Verfügung: Es bietet unter anderem zwei Höchstleistungsrechner, passende Rechenverfahren, gewaltige Speicherkapazitäten von mehreren Hundert Petabyte und rund 200 Experten zu verschiedensten Themen. Das JSC unterstützt ENVRI-FAIR beispielsweise beim Aufbau eines automatisierten Managements der großen Datenströme. Eines der Hauptthemen ist dabei der Datenzugriff. Denn immer öfter geht es heute darum, bei internationalen Projekten mit vielen Kooperationspartnern sicherzustellen, dass große Datensätze – und die daraus gezogenen Schlüsse – von allen beteiligten Forschergruppen durchleuchtet und verifiziert werden können.

Teamwork in Simulation Laboratories

Dafür werden in Jülich neue Rechnerarchitekturen entwickelt, die Big Data besonders gut bewältigen und auswerten können, wie JUWELS und DEEP. Um den Austausch zwischen Spezialisten für Hochleistungsrechner und Fachwissenschaftlern zu verbessern, hat das JSC außerdem sogenannte Simulation Laboratories eingerichtet, in denen die verschiedenen Experten eng zusammenarbeiten. Sie unterstützen Forscher beim allgemeinen Umgang mit Big Data und bei der Auswertung – auch mithilfe von maschinellem Lernen.

„Die Experten für Machine Learning und die Spezialisten für Hochleistungsrechner wissen, wie sich große Datenmengen mit den Supercomputern auswerten lassen. Fachwissenschaftler wie Biologen, Mediziner oder Werkstoffwissenschaftler können ihrerseits die sinnvollen Fragen an ihre spezifischen Daten stellen und die erzeugten Antworten bewerten lassen. Bei solcher Zusammenarbeit können so lernfähige Modelle – wie beispielsweise tiefe neuronale Netzwerke – mit den vorhandenen Daten trainiert werden, um Prozesse in der Atmosphäre, in biologischen Systemen, in Werkstoffen oder in einem Fusionsreaktor vorherzusagen“, erklärt Dr. Jenia Jitsev, Spezialist für Deep Learning und Maschinelles Lernen am JSC.

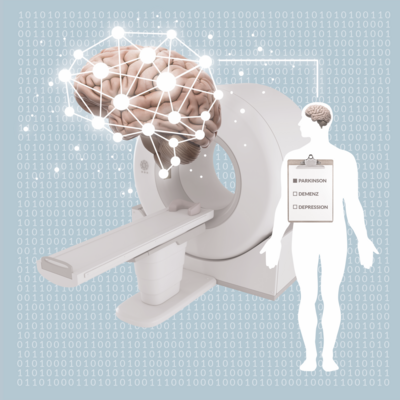

Einer der Jülicher Forscher, die eng mit dem JSC zusammenarbeiten, ist Dr. Timo Dickscheid, Leiter der Arbeitsgruppe Big Data Analytics vom Jülicher Institut für Neurowissenschaften und Medizin (INM-1). Auch in seinem Institut fallen enorm viele Daten an, denn es geht um das komplexeste Gebilde des Menschen: das Gehirn. „Wir entwickeln dafür ein dreidimensionales Modell, das sowohl strukturelle als auch funktionelle Organisationsprinzipien berücksichtigt“, so der Informatiker.

Er hat bereits an BigBrain mitgearbeitet, einem 3D-Modell, das aus Mikroskopaufnahmen von Gewebeschnitten des menschlichen Gehirns zusammengebaut wurde. 7 404 hauchdünne Schnitte hatten die Jülicher Hirnforscher dafür gemeinsam mit einem kanadischen Forscherteam in über 1 000 Arbeitsstunden präpariert und digitalisiert.

Durchs Gehirn surfen

„Dieses 3D-Gehirnmodell ist rund ein Terabyte groß“, berichtet Dickscheid, „da ist es bereits eine Herausforderung, den Bilddatensatz flüssig auf dem Bildschirm darzustellen – ganz abgesehen von aufwendigen Bildanalyseverfahren, die diesen Datensatz auf den Jülicher Supercomputern automatisch analysieren und so Stück für Stück dreidimensionale Karten der unterschiedlichen Hirnareale hinzufügen.“ Eine manuelle, lückenlose Einzeichnung dieser Areale durch die Wissenschaftler ist bei diesen Datengrößen nicht mehr machbar. Drei Jahre lang haben er und seine Kollegen intensiv programmiert und sich mit dem JSC ausgetauscht.

Das Ergebnis: Trotz der großen Datenbasis ermöglicht das Programm es, geschmeidig durch das Gehirn zu surfen und bis auf die Ebene von Zellverbänden zu zoomen. Der Trick: „Wir stellen dem Anwender nicht den ganzen Datensatz in voller Auflösung zur Verfügung, sondern nur den kleinen Teil, den er gerade anschaut“, erklärt Dickscheid. „Und zwar in Echtzeit“, fügt er hinzu. Das BigBrain-Modell und die 3D-Karten sind ein Paradebeispiel für geteilte Big Data. Sie können mittlerweile von jedermann im Internet angeklickt, gedreht, gezoomt und bestaunt werden.

Wissenschaftler aus aller Welt nutzen das. Denn durch die dreidimensionale Darstellung können sie räumliche Zusammenhänge in der komplizierten Architektur des menschlichen Gehirns weitaus besser beurteilen als bisher – und neue Erkenntnisse gewinnen. Niederländische Wissenschaftler etwa wollen mit dem Atlas die Sehrinde des Menschen auf zellulärer Ebene besser verstehen und mit diesem Wissen Neuroimplantate für Blinde verfeinern.

JUWELS und DEEP

JUWELS ist ein hochflexibler und modularer Supercomputer, dessen anpassungsfähiges Rechnerdesign in Jülich entwickelt wurde und auf ein erweitertes Aufgabenspektrum abzielt – von Big-Data-Anwendungen bis hin zu rechenaufwendigen Simulationen. Die Abkürzung steht für „Jülich Wizard for European Leadership Science“. Jülicher Forscher entwickeln zudem innerhalb der europäischen DEEP-Projekte neue modulare Supercomputer-Architekturen, die sich noch flexibler und effizienter als bisherige Systeme für wissenschaftliche Anwendungen nutzen lassen.

„Wir müssen uns in der Forschungsgemeinschaft darauf einigen, dass die Urheber der Daten künftig gleichberechtigt neben den Autoren einer wissenschaftlichen Publikation genannt werden.“

Katrin Amunts, Direktorin Institut für Neurowissenschaften und Medizin

„Ergebnisse wie unsere verschiedenen Gehirnkarten allen zugänglich zu machen, ist ein Grundpfeiler der Wissenschaft“, sagt Professorin Katrin Amunts, Direktorin am Institut für Neurowissenschaften und Medizin und Dickscheids Chefin. Die zugrundeliegenden Daten öffentlich zur Verfügung zu stellen, zwingt aber zu einem Paradigmenwechsel in der Forschung: „Veröffentlichungen von wissenschaftlichen Studien spielen im Moment noch eine sehr viel größere Rolle als Veröffentlichungen von Daten. Wir müssen uns in der Forschergemeinschaft darauf einigen, dass die Urheber der Daten gleichberechtigt neben den Autoren einer wissenschaftlichen Publikation genannt und zitiert werden. Auch hier sind FAIR Data ein ganz zentraler Punkt, Daten sollen findable, accessible, interoperable und reusable sein; ein Ansatz, den das Human Brain Project aktiv voranbringt“, betont Amunts. Denn Veröffentlichungen sind die Währung, mit der in der Forschung gehandelt und Karriere gemacht wird.

Teilen als Chance

Als leuchtendes Beispiel gelten die Astrophysiker. „Hier ist es historisch gewachsen, dass Daten unvoreingenommen geteilt werden“, weiß Dr. Ari Asmi von der Universität Helsinki, Kollege von Andreas Petzold und Mitkoordinator von ENVRI-FAIR. Das jüngste Beispiel ist das sensationelle Foto vom schwarzen Loch. „Das war nur möglich, weil die globale wissenschaftliche Gemeinschaft in der Radioastronomie erstens extrem eng vernetzt ist und zweitens ein Radioteleskop nur dann genutzt werden darf, wenn man seine damit erlangten Daten im Anschluss offenlegt.“

Aus Sicht von Asmi ist gerade das Teilen von Big Data eine große Chance für die Forschung: „Richtig spannend wird es, wenn wir es schaffen, anhand der neuen Methoden Daten aus verschiedenen Disziplinen miteinander zu verschränken, etwa unsere Umweltberechnungen mit Daten aus den Sozial-, Politik- und Wirtschaftswissenschaften. Gelingt das, werden wir tragfähige Modelle erhalten, um zum Beispiel den Klimawandel in seiner ganzen Bandbreite zu verstehen und Handlungskonzepte für die Zukunft erstellen zu können.“ Und dann wird Sammeln nicht nur Big, sondern wirklich Smart.

Autorin: Brigitte Stahl-Busse

Dieser Artikel ist zuerst in effzett - Das Magazin aus dem Forschungszentrum Jülich erschienen.