Mit Algorithmen gegen Schlammlawinen

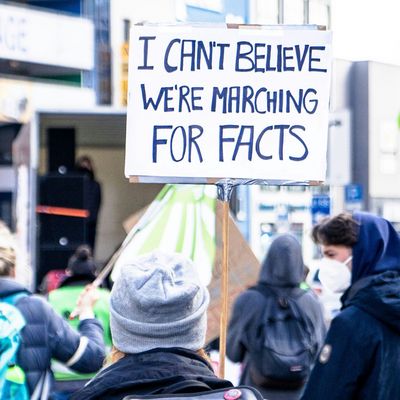

Um auf Extremwetterereignisse in Zukunft besser vorbereitet zu sein, versuchen Wissenschaftler am Helmholtz Zentrum für Umweltforschung Naturgesetze abzubilden - unterstützt von Algorithmen.

„Ich war schon immer neugierig auf die Welt draußen. Auf ihre Natur, die so unterschiedlich ist in den verschiedenen Ecken der Welt. Seit meiner Jugend liebe ich es, draußen zu sein. Kajaken, moutainbiken, wandern. Die Natur der Erde hat so ungeheuer viel zu bieten, es ist ein Wahnsinn, dass wir das gefährden. Dagegen wollte ich in meinem Beruf etwas tun. Ich entschied: Ich studiere Geografie. Denn in diesem Fach geht es um Umwelt und die Natur aus ganz unterschiedlichen Perspektiven.“

Wie wir Wasser besser verstehen

„Kennen Sie Hydrologie? Das war mein Schwerpunkt im Masterstudium an der Universität Freiburg. Die Wasserwissenschaften beschäftigen sich mit Fragen wie: Wann kommt es zu Überschwemmungen? Wie lassen sich Veränderungen des Grundwassers vorhersagen? Wie wird sich der Wasserhaushalt auf der Erde durch den Klimawandel verändern? Was heißt das für Landwirtschaft, Vegetation und Landnutzung? Die Forschung von Hydrologen liefert zentrale Daten, um die Folgen des Klimawandels besser zu verstehen.

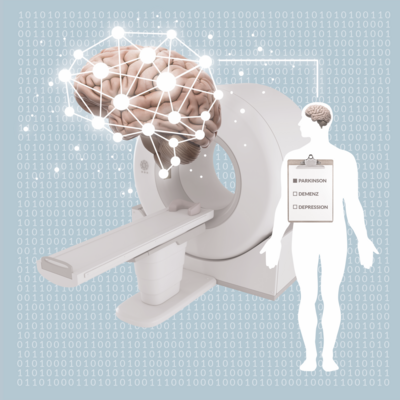

Bislang arbeiten wir in der Hydrologie noch vor allem mit physikalischen Modellen. Wir füttern sie mit Beobachtungsdaten und unserem Wissen über die Zusammenhänge. Zum Beispiel: Wie viel Wasser versickert und verdunstet in Abhängigkeit von Regen, Sonneneinstrahlung, Bodenbeschaffenheit, Pflanzenbewuchs? Das Problem: Die Modelle haben Lücken, weil wir an vielen Stellen noch nicht genau verstanden haben, wie die verschiedenen Parameter genau zusammenhängen. Wieviel CO2 aus dem Boden zum Beispiel nimmt die Atmosphäre auf? Wir wissen zwar, dass dieser Austausch von mikrobakteriellen Prozessen im Boden abhängt, von Parametern wie Vegetation oder Temperatur. Doch wir wissen wenig darüber, wie das genau abläuft. Diese Lücken können wir nun mit algorithmischen Big Data-Modellen füllen.“

Daten und Algorithmen bringen uns im Kampf gegen den Klimawandel weiter

„Im Masterstudium habe ich verstanden: Statistik und Simulationen können der Schlüssel zur Lösung vieler Klimaprobleme sein. Wenn es uns gelingt, Naturgesetzte in Algorithmen abzubilden, können wir daraus Modelle bauen, die uns erlauben, die Zukunft vorherzusagen. Zwei Entwicklungen machen das jetzt möglich: Big Data und die gewaltigen Fortschritte der Künstlichen Intelligenz.

Heute können wir so viele Daten wie nie zuvor sammeln und speichern. Neue Sensoren sammeln überall in der Umwelt neue Daten zur Hydrologie, von Grundwasserständen über Vegetation und Bodenfeuchte bis zur Landnutzung. Hochleistungsrechner speichern diese Informationen in gewaltigen Datenbanken.

Zum anderen können wir mithilfe von Künstlicher Intelligenz und Maschine Learning diese gewaltigen Datenmengen endlich effektiv nutzen. Das neue große Ding sind algorithmische Big Data-Modelle. Der Clou: Wenn wir Algorithmen mit Millionen Daten trainieren, lernen sie Muster. Man könnte auch sagen: Sie lernen Beziehungen. Wenn, dann. Diese Muster ermöglichen uns Vorhersagen, wie sich Dinge entwickeln werden – auch wenn die Daten unvollständig sind.

So fehlen häufig Daten von Stauseen, wenn wir mit einem physikalischen Modell vorhersagen möchten, wie sich der Wasserstand eines Flusses entwickeln wird. Denn manche Betreiber geben diese Daten nicht heraus. Ein Algorithmus-basiertes Modell kann diese Lücke füllen, indem es aus vorhandenen Daten Wahrscheinlichkeiten errechnet. Wie viel Wasser strömt in den Stausee rein, wieviel raus, wie viel hat es geregnet?

Je mehr Daten und Erkenntnisse aus unterschiedlichen Disziplinen wir in solche Modelle einspeisen, desto besser sind die Ergebnisse. Im Programm „Digital Earth“ arbeiten gerade Forscher mehrerer Helmholtz-Zentren und Forschungsbereiche unter Hochdruck daran. Zum Beispiel um Hochwasserrisiken in der Klimakrise genauer prognostizieren zu können und die erratischen Langzeiteffekte auf das Land- und Küstensystem besser zu verstehen. Das erfordert ganz schön viel Datenmanagement. Und genau das ist zur Zeit der Knackpunkt.“

Was ich für die Rettung der Welt tun will

„Ich möchte, dass wir Daten noch viel besser nutzen als bisher. Dafür müssen wir Formate und Methoden vereinheitlichen und gemeinsame Schnittstellen definieren. Nur so lassen sich Daten aus völlig unterschiedlichen Feldern zusammenführen und für die Forschung nutzbar machen.

Wir müssen dabei Wege finden, all die Messdaten automatisiert auszuwerten. Und die Ergebnisse narrensicher zu machen. Denn in vielen Daten verstecken sich Fehler. Wenn zum Beispiel ein Regenwurm an einem Bodensensor vorbeikriecht, verändert sich das Signal. Wenn Blätter einen Niederschlagssammler verkleben, liefert er falsche Daten. Die Fehler in Millionen Daten können wir nicht überall alleine finden. Dafür brauchen wir künstliche Intelligenz, ein maschinell lernendes Modell.“

Aufgezeichnet von Anja Dilk