"Jeder Remix war einzigartig"

Lynn von Kurnatowski vom DLR hat in Zusammenarbeit mit dem HIDA-Stipendiaten Martin Hennecke, einen besonderen Algorithmus entwickelt: Er erschafft aus biometrischen Daten einen Live-Remix eines Musikstücks. Wir haben mit ihr über die interdisziplinäre Projektarbeit gesprochen.

In “The (Un)Answered Question“ wurden verschiedene Körperdaten des Publikums und auch der Performer erfasst – beispielsweise der Herzschlag, Gesichtsausdruck usw. Ein intelligenter Algorithmus sammelte diese verschiedenen Biodaten und verarbeitete sie zu Videoprojektionen und einem orchestralen Live-Remix der Originalkomposition. Wie sind Sie auf diese endgültige Idee gekommen?

Die Idee, das Publikum mit einzubeziehen, gab es von Anfang an. Das war Martin wichtig. Der grobe Plan zu Beginn war es, Daten vom Publikum aufzuzeichnen und diese zu einem Orchester-Remix der Originalkomposition zu verarbeiten. Da gab es dann gewisse Aspekte, die geklärt werden mussten. Beispielsweise: Welche Daten können wir überhaupt aufzeichnen? Man kann ja sowohl subjektive als auch objektive Daten erfassen. Da war schnell klar: Wir möchten mithilfe eines Fragebogens Persönlichkeitsmerkmale ermitteln und diese mit den biometrischen Daten kombinieren.

Bei den objektiven Daten mussten wir dann aber die Vorgehensweise klären. Wenn wir im Labor Studien durchführen, dann sitzt dort meistens nur eine Person in einem ganz geregelten Umfeld. Wir können zudem auch spezifisch auf etwaige Bedürfnisse eingehen. Wenn dann etwas nicht geklappt hat, kann die Studie wiederholt werden. In diesem Fall ging das nicht: Es waren 180 Personen im Saal. Wir konnten nicht über das ganze Theater die Kabel verlegen. Das heißt, da ging es natürlich erst mal um die Frage: Welche Sensoren können wir überhaupt einsetzen, um die biometirischen Daten des Publikums zu erfassen?

Nachdem das geklärt war, kam direkt die nächste Fragestellung: Wie entstehen aus den Daten, die wir erhoben haben, jetzt Noten? Im Endeffekt wollten wir einen intelligenten Algorithmus entwickeln, der aus den biometrischen Daten automatisiert einen Remix erstellt. Dabei mussten wir gemeinsam mit Martin überlegen: Was ist technisch möglich? Und was ist künstlerisch überhaupt möglich? Da ging die Zusammenarbeit dann wirklich richtig los, wo wir uns dann konkret Gedanken gemacht haben.

Unsere Gesprächspartnerin Lynn von Kurnatowski

Lynn von Kurnatowski

Lynn von Kurnatowski studierte Informatik an der Friedrich-Alexander-Universität Erlangen-Nürnberg und schloss mit dem Master of Science ab. Seit 2018 ist sie wissenschaftliche Mitarbeiterin in der Gruppe Intelligente und Verteilte Systeme am Institut für Softwaretechnik des Deutschen Zentrums für Luft- und Raumfahrt (DLR). Dort arbeitet sie an der systematischen Analyse von Software-Repositories mit dem langfristigen Ziel, den allgemeinen Entwicklungsprozess von Softwaresystemen im Forschungskontext zu optimieren. Neben der Software-Analytik beschäftigt sie sich mit dem Thema Human Factors im Software Engineering. Dabei kommen qualitative und quantitative Methoden zum Einsatz, um die Zusammenhänge zwischen menschlichen Faktoren und softwaretechnischen Phänomenen zu verstehen.

Was hat Ihre Abteilung am Projekt „The (Un)Answered Question“ gereizt?

Ich glaube, da kann ich für alle Beteiligten aus unserer Abteilung sprechen, dass uns die Einzigartigkeit von Martins (Hennecke Anm. der Redaktion) Projekt interessiert hat. Es hat uns außerdem gereizt, die zwei Themen – Kunst und Wissenschaft – zusammenzubringen und interdisziplinär zu arbeiten.

Denn es ist sehr spannend, Aspekte, die wir in unserer täglichen Arbeit bearbeiten, in einen ganz anderen Kontext zu setzen. Weswegen wir uns wirklich sehr gefreut haben, dass dieses Projekt auch zustande gekommen ist.

In der ersten Besprechung wurde uns bewusst, dass wir überhaupt erst einmal eine gemeinsame Sprache finden mussten.

Wie ist denn aus dem Algorithmus Musik entstanden? Funktionierte es nach dem Motto: Der Herzschlag wird schneller, also wird der Rhythmus des Lieds schneller? Oder wie kann man sich das vorstellen?

Genau diese lineare Zuordnung wollten wir nicht. Das war uns wichtig, dass wir nicht einfach sagen „Okay, der Puls beeinflusst die Streicher und die Gesichtserkennung beeinflusst die Trompete“. Wir wollten eine intelligente Zuordnung. Und deshalb haben wir unsere alltägliche Arbeit untersucht und Methodiken zweckentfremdet. Da kam schnell die Idee auf, dass wir die Daten clustern. Mithilfe des Mittelpunkts des Clusters haben wir dann bestimmte Aspekte der Originalkomposition manipuliert. Dabei waren wir bei der Musik natürlich an gewisse Grenzen gebunden, denn das Stück, das am Ende rauskommt, musste für das Orchester ja noch spielbar sein. Es konnte also beispielsweise nicht unendlich schnell werden. Trotzdem haben wir so eine lineare Zuordnung vermeiden können und jeder Remix war einzigartig.

Was waren Herausforderungen, denen Sie im Projekt begegnet sind? Wie haben Sie diese dann gelöst?

Unsere größte Herausforderung war natürlich das Umfeld. Wir wussten, dass im Saal 180 Leuten sein würden. Das war keine Laborstudie, es musste alles auf den Punkt genau funktionieren. Wir hatten vor der Uraufführung zuvor eine Probeaufführung in Dortmund an der Akademie für Theater und Digitalität mit 15 Zuschauern. Die Probeführung hat ganz gut geklappt. Aber das musste man eben auf 180 Menschen skalieren.

So wollten wir eigentlich zunächst alle Daten von einem Rechner erfassen lassen und diese über einen zweiten dann auswerten. Wir haben schnell gemerkt, dass das über die Leistungsfähigkeit der Rechner ging. Also mussten wir die Datenerfassung auf mehrere Computer aufteilen. Wir haben dann beispielsweise zwei Rechner für die Daten aus den Fitnesstrackern genutzt – einen für die linke und einen für die rechte Seite des Zuschauerraums. Die zweite Herausforderung war natürlich, dass wir nicht viel Zeit hatten, um die Rohdaten aufzubereiten und daraus dann Noten zu generieren. Das musste alles in fünf Minuten geschehen, also musste einiges parallel laufen.

Über das Projekt "The (Un)Answered Question"

The (Un)Answered Question

In dem Projekt „The (Un)Answered Question – Eine musikalische Data Science Versuchsanordnung“ werden ausgewählte Methoden und Techniken der Datenwissenschaft mit konzeptionellen und kompositorischen Ideen aus Theater und Musik kombiniert.

Ausgehend von Ralph Waldo Emersons Gedicht „The Sphynx“ und dem Stück „The Unanswered Question“ des amerikanischen Komponisten Charles Ives entwickelte und erforschte Martin Hennecke einen Prototyp für eine besondere Aufführung. Beide Werke werden miteinander verwoben und während der Aufführung modifiziert, je nach Gemütszustand und körperlicher Verfassung der ausführenden Künstler oder der Zuschauer.

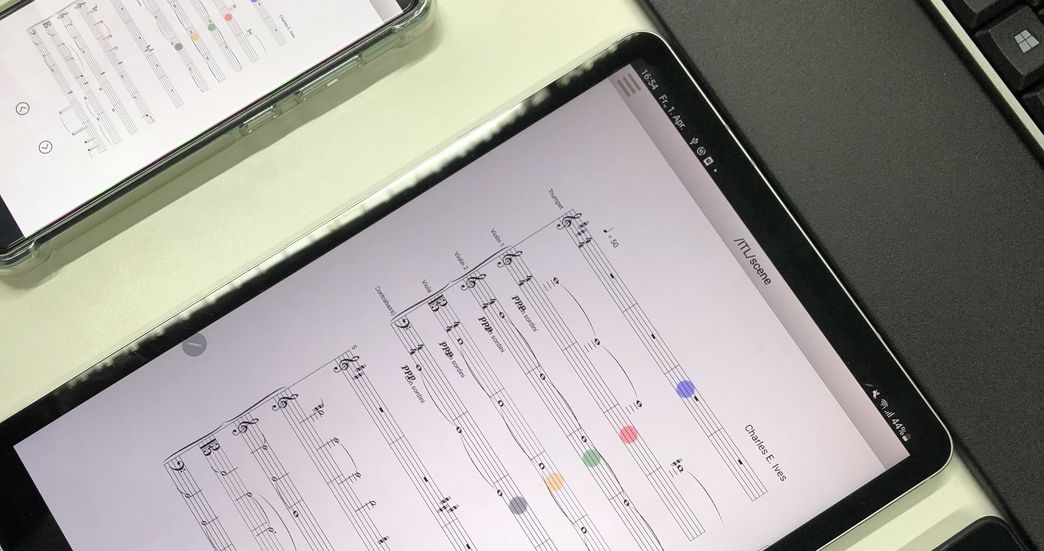

Ausschlaggebend für das jeweilige Ergebnis sind verschiedene Körperdaten des Publikums und der Performer, zum Beispiel der Herzschlag oder der Gesichtsausdruck, die mittels Fitness-Tracker oder Emotionserkennung über Bilderkennungssoftware erfasst werden. Ein intelligenter Algorithmus sammelt diese verschiedenen Biodaten und verarbeitet sie zu Videoprojektionen und einem orchestralen Live-Remix der Originalkomposition. Dieser Remix wird zu einer neuen Partitur, die in einzelnen Teilen auf Tablets für die Musiker gestreamt wird. – Das Ergebnis ist ein immersives und exklusives Live-Erlebnis, an dem Zuhörer und Interpreten gleichermaßen teilhaben.

An dem Projekt beteiligt waren ebenfalls die Berlin Ultrahigh Field Facility am Max-Delbrück-Centrum für Molekulare Medizin und das Institut für Softwaretechnologie des Deutschen Zentrums für Luft und Raumfahrt.

Nähere Informationen zu Konzept und Durchführung des Projekts können Sie in diesem Wiki nachlesen.

Sicherlich war auch die interdisziplinäre Zusammenarbeit spannend. Was waren interessante Punkte bei der Zusammenarbeit mit den Künstlern?

In der ersten Besprechung wurde uns bewusst, dass wir überhaupt erst einmal eine gemeinsame Sprache finden mussten. So hatten wir regelmäßige Meetings mit Martin, in denen wir als Team über das Projekt gesprochen haben und Diskussionen entstanden sind. Da musste er manchmal sagen „Wenn ihr dieser Meinung seid, dann wird das schon richtig sein. Ich vertraue euch mal.“ Genauso kam es andersherum vor, dass er Fachbegriffe aus Kunst und Musik nutzte, die wir nicht kannten. Das war schon lustig.

Spannend war auch die Zusammenarbeit mit dem Orchester. Wir wussten nicht, wie die Musikerinnen und Musiker darauf reagieren werden. Der Dirigent erzählte, dass sie normalerweise die Noten vier Wochen vor dem Auftritt erhalten, um sich vorzubereiten. Bei unserem Projekt erhielten sie ja die neuen Noten direkt auf das Tablet und mussten sie sofort spielen. Das war sehr interessant bei der Aufführung mitzuerleben.

Sie möchten über dieses Projekt nun auch eine wissenschaftliche Publikation veröffentlichen. Was können andere Wissenschaftler aus Ihren Erfahrungen lernen?

Es gibt ja immer mehr Tracks – auch bei Konferenzen – die sich mit "Software Engineering in Society" beschäftigen, die genau diesen interdisziplinären Aspekt, den wir im Projekt miterlebt haben, ansprechen. Außerdem nehmen wir aus diesem Projekt auch fachlich viel für unsere eigene Arbeit mit – vor allem bezüglich des Arbeitens mit biometrischen Daten.

Eine kleine Zukunftsfrage zum Schluss: Welche andere Kunstform würden Sie denn jetzt gerne vielleicht auch mal mit Data Science verändern?

Ich finde Musik, gerade Orchestermusik, bietet noch großes Potential und ist ein spannender Bereich. Deshalb würde ich gar nicht mal sagen, welche andere Kunstform, sondern finde es interessanter, daran zu bleiben und das noch zu erweitern. Vielleicht weitere biometrische Daten oder weitere Komponenten hinzufügen. Man ist da noch am Anfang, da lässt sich noch viel machen.

Das Interview führte Laila Oudray